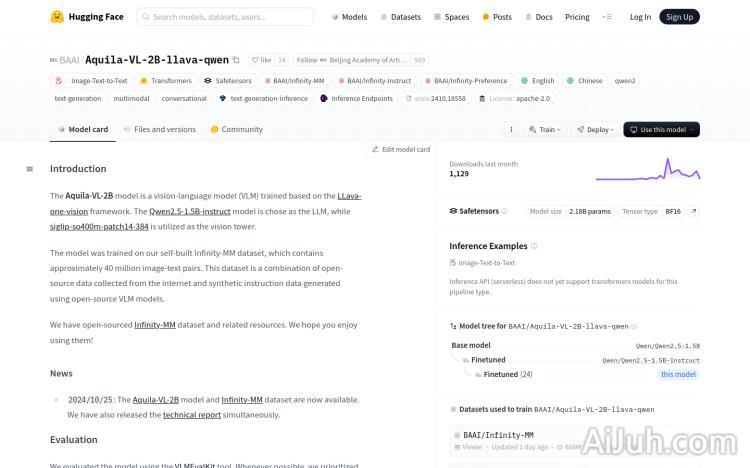

Aquila-VL-2B-llava-qwen官网

Aquila-VL-2B模型是一个基于LLava-one-vision框架训练的视觉语言模型(VLM),选用Qwen2.5-1.5B-instruct模型作为语言模型(LLM),并使用siglip-so400m-patch14-384作为视觉塔。该模型在自建的Infinity-MM数据集上进行训练,包含约4000万图像-文本对。该数据集结合了从互联网收集的开源数据和使用开源VLM模型生成的合成指令数据。Aquila-VL-2B模型的开源,旨在推动多模态性能的发展,特别是在图像和文本的结合处理方面。

Aquila-VL-2B-llava-qwen是什么

Aquila-VL-2B-llava-qwen是一个强大的开源视觉语言模型(VLM),它能够理解并处理图像和文本信息。它基于LLaVA-one-vision框架,采用Qwen2.5-1.5B-instruct作为语言模型,并使用siglip-so400m-patch14-384作为视觉塔。该模型在包含约4000万图像-文本对的Infinity-MM数据集上进行训练,具备强大的图像-文本到文本转换能力,支持多种语言(包括中文和英文),并支持多模态和对话生成。

Aquila-VL-2B-llava-qwen主要功能

Aquila-VL-2B-llava-qwen的主要功能包括:图像-文本到文本转换、多模态理解、图像识别、文本生成、多语言支持(中文、英文等)、对话生成以及文本生成推理。它可以将图像和文本信息结合起来进行智能处理,例如根据图片生成描述性文本,或者根据图像和文本进行问答等。

如何使用Aquila-VL-2B-llava-qwen

使用Aquila-VL-2B-llava-qwen需要先安装LLaVA-NeXT库。然后,通过llava.model.builder中的load_pretrained_model函数加载预训练模型。接下来,需要准备图像数据(使用PIL库加载并使用llava.mm_utils中的process_images函数处理),构建对话模板,生成提示,将提示编码为模型可理解的输入格式,调用模型的generate函数生成文本输出,最后解码输出为可读文本。整个流程涉及到图像处理、提示工程和模型调用等多个步骤。

Aquila-VL-2B-llava-qwen产品价格

作为开源模型,Aquila-VL-2B-llava-qwen本身是免费使用的。但是,使用该模型可能需要一定的计算资源,这部分成本需要用户自行承担。

Aquila-VL-2B-llava-qwen常见问题

这个模型的训练数据是什么?它的准确性如何?

该模型在Infinity-MM数据集上进行训练,该数据集包含约4000万图像-文本对,结合了互联网开源数据和合成数据。模型的准确性取决于训练数据质量和模型架构,实际应用中需要根据具体任务进行评估。

如何处理模型输出的错误或不准确信息?

模型输出可能存在错误或不准确信息,这与模型的局限性和训练数据有关。建议用户对模型输出进行人工审核和校对,并根据实际需求对模型进行微调或使用其他方法进行补充。

这个模型支持哪些类型的图像和文本?

该模型支持多种类型的图像和文本,但其性能可能因图像和文本的质量、复杂度而异。建议用户在使用前了解模型的适用范围,并根据实际情况进行调整。

Aquila-VL-2B-llava-qwen官网入口网址

https://huggingface.co/BAAI/Aquila-VL-2B-llava-qwen

OpenI小编发现Aquila-VL-2B-llava-qwen网站非常受用户欢迎,请访问Aquila-VL-2B-llava-qwen网址入口试用。

数据统计

数据评估

本站Home提供的Aquila-VL-2B-llava-qwen都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2025年 1月 9日 下午10:01收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。