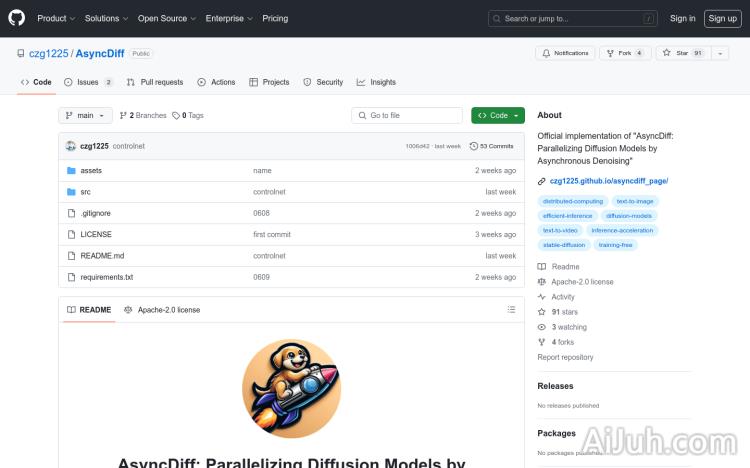

AsyncDiff官网

异步去噪并行化扩散模型

AsyncDiff简介

需求人群:

"AsyncDiff 适合需要进行高效图像生成和视频生成的研究人员和开发者。特别适用于寻求降低深度学习模型推理时间,同时保持生成内容质量的应用场景。"

使用场景示例:

使用 AsyncDiff 加速 Stable Diffusion XL 的图像生成过程

通过 AsyncDiff 并行化处理 ControlNet 模型以提升视频生成效率

利用 AsyncDiff 对 Stable Diffusion x4 Upscaler 进行加速,以快速生成高分辨率图像

产品特色:

支持多种扩散模型并行化加速,如Stable Diffusion 2.1、Stable Diffusion 1.5、Stable Diffusion x4 Upscaler等。

通过分割噪声预测模型实现设备间的并行计算,有效降低推理延迟。

减少推理延迟,保持生成质量,适用于高效的图像和视频生成。

提供详细的脚本以加速特定模型的推理过程,方便用户进行定制化优化。

支持 ControlNet、Stable Diffusion XL 等多种模型,灵活适应不同的应用场景。

提供灵活的配置选项以适应不同的并行计算需求,使得异步并行推理更加方便。

易于集成,仅需添加少量代码即可启用异步并行推理,降低开发成本。

使用教程:

安装必要的环境和依赖,包括 NVIDIA GPU、CUDA 和 CuDNN,确保系统支持并行计算。

创建 Python 环境并激活,然后安装 AsyncDiff 的依赖包,以便进行异步并行推理。

在现有的扩散模型代码中引入 AsyncDiff,并进行必要的配置,比如分割数量和去噪步长。

根据需求选择并配置模型分割的数量、去噪步长和预热阶段,以满足不同的并行计算需求。

运行提供的示例脚本或自定义脚本来执行并行推理,评估加速效果。

根据输出结果评估 AsyncDiff 加速效果,并进行必要的调整,以达到最佳性能。

AsyncDiff官网入口网址

https://github.com/czg1225/AsyncDiff

小编发现AsyncDiff网站非常受用户欢迎,请访问AsyncDiff网址入口试用。

数据统计

数据评估

本站Home提供的AsyncDiff都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2024年 7月 4日 下午9:23收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。