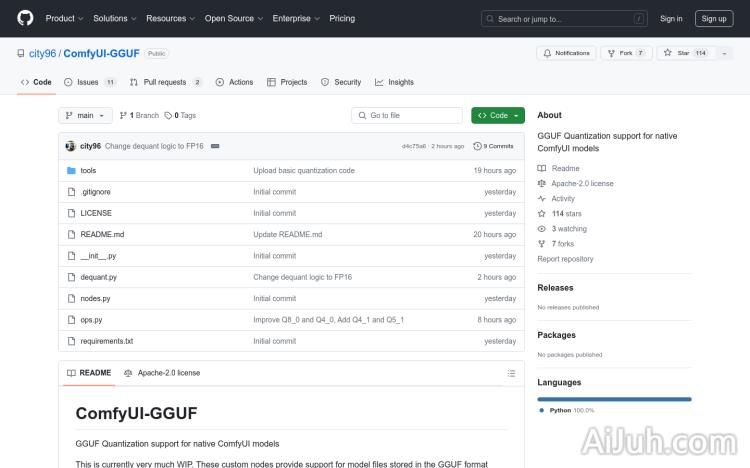

ComfyUI-GGUF官网

GGUF量化支持,优化ComfyUI原生模型性能

ComfyUI-GGUF简介

需求人群:

"目标受众主要是使用ComfyUI进行模型训练和部署的开发者和研究人员。他们需要在资源受限的环境中优化模型性能,ComfyUI-GGUF通过量化技术帮助他们实现这一目标。"

使用场景示例:

开发者使用ComfyUI-GGUF在低端GPU上部署flux模型,实现资源优化。

研究人员利用GGUF量化技术,提升了模型在边缘设备上的性能。

教育机构在教授深度学习时,使用ComfyUI-GGUF作为案例,教授模型优化技巧。

产品特色:

支持GGUF格式模型文件的量化

适用于transformer/DiT模型,如flux

允许在低端GPU上运行,优化资源使用

提供了自定义节点以支持模型量化

不包括LoRA / Controlnet等支持,因为权重已被量化

提供了安装和使用指南

使用教程:

1. 确保ComfyUI版本支持自定义操作。

2. 使用git克隆ComfyUI-GGUF仓库。

3. 安装推理所需的依赖项(pip install –upgrade gguf)。

4. 将.gguf模型文件放置在ComfyUI/models/unet文件夹中。

5. 使用GGUF Unet加载器,该加载器位于bootleg类别下。

6. 根据需要调整模型参数和设置,进行模型训练或推理。

ComfyUI-GGUF官网入口网址

小编发现ComfyUI-GGUF网站非常受用户欢迎,请访问ComfyUI-GGUF网址入口试用。

数据统计

数据评估

本站Home提供的ComfyUI-GGUF都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2024年 9月 5日 下午4:07收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。