Crawl4LLM官网

Crawl4LLM是一个开源的网络项目,旨在为大型语言模型(LLM)的预训练提供高效的数据爬取解决方案。它通过智能选择和爬取网页数据,帮助研究人员和开发者获取高质量的训练语料。该工具支持多种文档评分方法,能够根据配置灵活调整爬取策略,以满足不同的预训练需求。项目基于Python开发,具有良好的扩展性和易用性,适合在学术研究和工业应用中使用。

Crawl4LLM是什么?

Crawl4LLM是一个开源的Python网络工具,专门为大型语言模型(LLM)的预训练提供高效的数据爬取解决方案。它能够智能地选择和爬取高质量的网页数据,帮助研究人员和开发者获取用于训练LLM的优质语料。Crawl4LLM支持多种文档评分方法和灵活的配置选项,使其能够适应不同的预训练需求,并支持与DCLM框架集成,方便后续的模型训练和评估。

Crawl4LLM的主要功能

Crawl4LLM的主要功能包括:高效爬取高质量网页数据;支持多种文档评分方法(例如基于长度、基于fastText模型评分);灵活配置爬取策略和参数;支持多线程和大规模数据处理;与DCLM框架集成;支持从ClueWeb22等大型数据集爬取数据;提供日志记录和状态保存功能;支持多种基线策略(例如随机、基于入度)。

如何使用Crawl4LLM?

使用Crawl4LLM进行数据爬取主要包括以下步骤:1. 准备环境:请求ClueWeb22数据集(或其他数据源)并准备Python虚拟环境,安装必要的依赖库(numpy、tqdm、fasttext等),下载DCLM fastText分类器。2. 配置爬取:创建配置文件,设置爬取参数和策略,例如目标网站、爬取深度、评分方法等。3. 开始爬取:运行`crawl.py`脚本开始爬取数据。4. 获取数据:使用`fetch_docs.py`获取爬取的文档文本。5. 模型训练:结合DCLM框架进行LLM预训练和评估。

Crawl4LLM的产品价格

Crawl4LLM是一个开源项目,完全免费使用。

Crawl4LLM的常见问题

ClueWeb22数据集获取困难怎么办? 可以尝试寻找其他公开的数据集替代,或者自行构建数据集。

如何自定义Crawl4LLM的爬取策略? 通过修改配置文件中的参数,例如设置不同的评分方法、爬取深度、线程数等,可以自定义爬取策略。详细配置参数说明请参考项目文档。

Crawl4LLM的爬取速度慢怎么办? 可以尝试增加爬取线程数,优化配置文件中的参数,或者检查网络连接是否稳定。

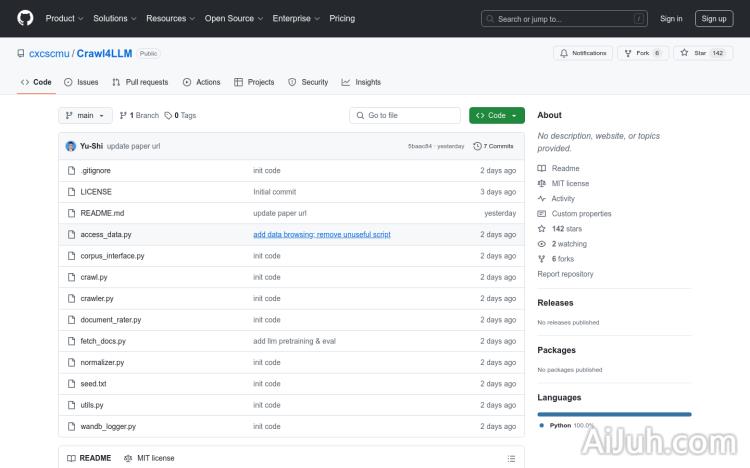

Crawl4LLM官网入口网址

https://github.com/cxcscmu/Crawl4LLM

OpenI小编发现Crawl4LLM网站非常受用户欢迎,请访问Crawl4LLM网址入口试用。

数据统计

数据评估

本站Home提供的Crawl4LLM都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2025年 2月 24日 下午4:13收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。