In-Context LoRA for Diffusion Transformers官网

In-Context LoRA是一种用于扩散变换器(DiTs)的微调技术,它通过结合图像而非仅仅文本,实现了在保持任务无关性的同时,对特定任务进行微调。这种技术的主要优点是能够在小数据集上进行有效的微调,而不需要对原始DiT模型进行任何修改,只需改变训练数据即可。In-Context LoRA通过联合描述多张图像并应用任务特定的LoRA微调,生成高保真度的图像集合,更好地符合提示要求。该技术对于图像生成领域具有重要意义,因为它提供了一种强大的工具,可以在不牺牲任务无关性的前提下,为特定任务生成高质量的图像。

In-Context LoRA for Diffusion Transformers产品简介

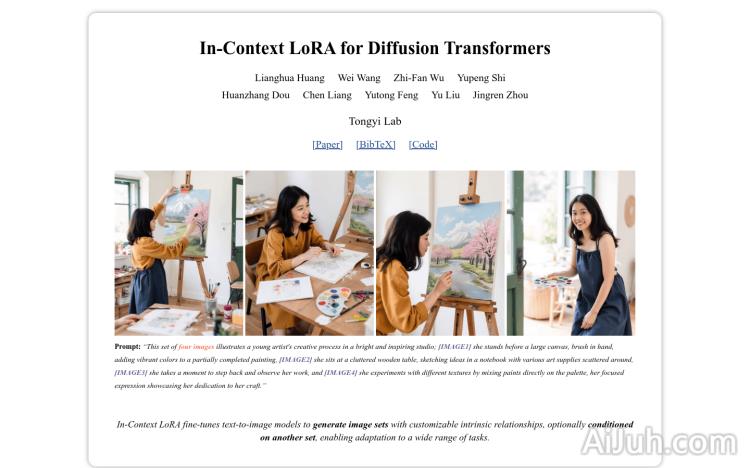

In-Context LoRA 是一种用于扩散变换器 (DiT) 的高效微调技术,它允许用户在保持模型通用性的同时,针对特定图像生成任务进行微调。该技术尤其擅长于使用少量数据 (20-100 个样本) 进行训练,无需修改原始 DiT 模型本身。通过联合描述多张图像并应用任务特定的 LoRA 微调,In-Context LoRA 可以生成高质量、与提示高度一致的图像集合。

In-Context LoRA for Diffusion Transformers主要功能

In-Context LoRA 的核心功能在于其高效的微调能力。它允许用户通过少量图像和文本数据,快速训练 DiT 模型以适应特定任务。其主要功能包括:联合描述多张图像以提高生成图像的一致性;使用任务特定的 LoRA 微调,减少计算成本和数据需求;生成高保真度、符合提示要求的图像集合;保持模型的通用性和任务无关性;无需修改原始 DiT 模型。

In-Context LoRA for Diffusion Transformers使用方法

使用 In-Context LoRA 进行图像生成和微调的过程相对简单:首先,准备一组包含图像和相应描述文本的数据集;然后,使用 In-Context LoRA 模型对图像和文本进行联合描述;接下来,选择一个小数据集进行任务特定的 LoRA 微调;微调完成后,即可使用微调后的模型生成新的图像;最后,评估生成的图像质量并根据需要进一步微调模型。

In-Context LoRA for Diffusion Transformers产品价格

本文未提供 In-Context LoRA 的价格信息。建议访问其官方网站 (https://ali-vilab.github.io/In-Context-LoRA-Page/) 获取最新信息或联系相关开发者。

In-Context LoRA for Diffusion Transformers常见问题

该技术是否需要强大的计算资源? In-Context LoRA 的优势之一就在于其对计算资源的需求相对较低,因为它只需要微调少量参数,而不是整个模型。因此,即使是中等配置的机器也能胜任。

与其他微调方法相比,In-Context LoRA 的优势是什么? In-Context LoRA 能够在保持模型任务无关性的同时,通过少量数据高效地进行微调,这使其在效率和通用性方面优于一些需要大量数据或修改模型架构的其他方法。

In-Context LoRA 支持哪些类型的图像生成任务? 该技术支持多种图像生成任务,包括但不限于电影故事板生成、人像摄影和字体设计。其适应性强,可以应用于各种需要高质量图像生成的场景。

In-Context LoRA for Diffusion Transformers官网入口网址

https://ali-vilab.github.io/In-Context-LoRA-Page/

OpenI小编发现In-Context LoRA for Diffusion Transformers网站非常受用户欢迎,请访问In-Context LoRA for Diffusion Transformers网址入口试用。

数据统计

数据评估

本站Home提供的In-Context LoRA for Diffusion Transformers都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2025年 1月 10日 上午3:54收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。