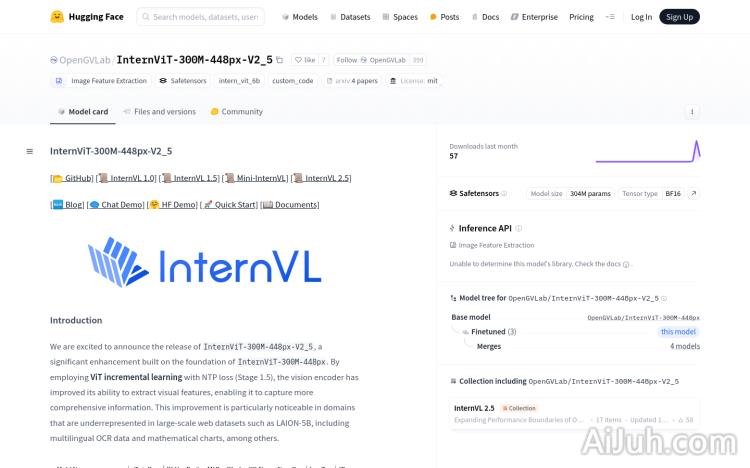

InternViT-300M-448px-V2_5官网

InternViT-300M-448px-V2_5是一个基于InternViT-300M-448px的增强版本,通过采用ViT增量学习与NTP损失(Stage 1.5),提升了视觉编码器提取视觉特征的能力,尤其是在大规模网络数据集中代表性不足的领域,如多语言OCR数据和数学图表等。该模型是InternViT 2.5系列的一部分,保留了与前代相同的“ViT-MLP-LLM”模型架构,并集成了新的增量预训练的InternViT与各种预训练的LLMs,如InternLM 2.5和Qwen 2.5,使用随机初始化的MLP投影器。

InternViT-300M-448px-V2_5是什么

InternViT-300M-448px-V2_5是基于InternViT-300M-448px改进的视觉编码器模型。它通过ViT增量学习和NTP损失函数的应用,显著提升了在处理大规模数据集(尤其是在多语言OCR数据和数学图表等领域)中的视觉特征提取能力。该模型是InternViT 2.5系列的一部分,沿用了“ViT-MLP-LLM”架构,并结合了InternLM 2.5和Qwen 2.5等预训练大型语言模型,使用随机初始化的MLP投影器。简单来说,它是一个更强大、更擅长处理特定类型视觉数据的图像识别模型。

InternViT-300M-448px-V2_5主要功能

InternViT-300M-448px-V2_5的主要功能在于高效的视觉特征提取。它尤其擅长处理在大型互联网数据集里代表性不足的图像类型,例如多语言的OCR文本和复杂的数学图表。其应用场景涵盖图像分类、语义分割、多模态学习等领域。得益于增量学习和NTP损失的运用,该模型能更好地处理这些数据,提高识别准确率和效率。

如何使用InternViT-300M-448px-V2_5

使用InternViT-300M-448px-V2_5需要一定的编程基础。大致步骤如下:首先,导入必要的库,如PyTorch和Transformers;然后,从Hugging Face模型库加载InternViT-300M-448px-V2_5模型;接着,使用PIL库打开并处理图像(转为RGB格式);再使用CLIPImageProcessor处理图像并获取像素值;将像素值转换为模型所需的数据类型并传输到GPU;最后,将处理后的数据输入模型,获取模型输出结果。Hugging Face提供了详细的文档和代码示例,可以帮助用户快速上手。

InternViT-300M-448px-V2_5产品价格

本文档并未提供InternViT-300M-448px-V2_5的定价信息。由于该模型通常通过Hugging Face等平台开放访问,因此其使用可能不需要直接付费,但可能需要考虑计算资源成本(例如云计算费用)。

InternViT-300M-448px-V2_5常见问题

该模型的训练数据是什么? 该模型的训练数据包含了大量的图像数据,具体细节可以在Hugging Face的模型页面上找到。它特别关注在大型互联网数据集里代表性不足的数据,例如多语言OCR数据和数学图表数据。

如何评估InternViT-300M-448px-V2_5的性能? 可以通过标准的图像识别评估指标,例如准确率、召回率、F1值等来评估模型性能。 具体方法取决于你的应用场景和评估数据集。Hugging Face也提供了一些性能基准数据。

该模型适用于哪些类型的图像? 该模型适用于各种类型的图像,但其优势在于处理在大型互联网数据集里代表性不足的数据,例如多语言OCR数据和复杂的数学图表数据。 对于一般的图像分类和识别任务,它也能提供良好的性能。

InternViT-300M-448px-V2_5官网入口网址

https://huggingface.co/OpenGVLab/InternViT-300M-448px-V2_5

OpenI小编发现InternViT-300M-448px-V2_5网站非常受用户欢迎,请访问InternViT-300M-448px-V2_5网址入口试用。

数据统计

数据评估

本站Home提供的InternViT-300M-448px-V2_5都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2025年 1月 10日 上午3:39收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。