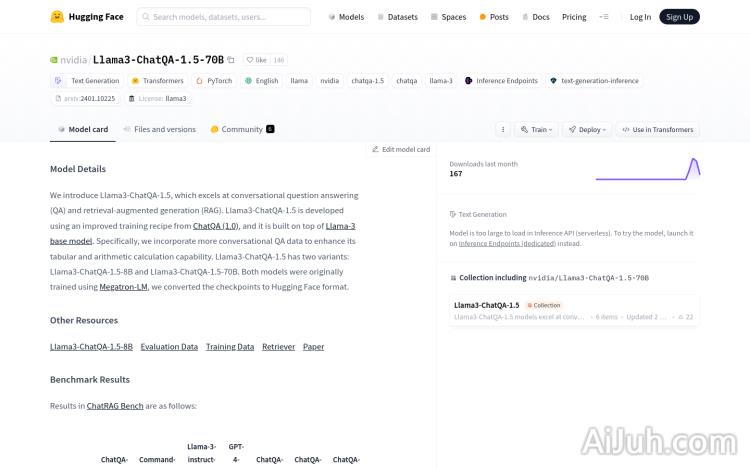

Llama3-ChatQA-1.5-70B官网

一款基于NVIDIA的高性能对话式问答和检索增强型生成模型。

Llama3-ChatQA-1.5-70B简介

需求人群:

["研究人员和开发者:可以利用该模型进行高级的自然语言处理研究和开发。","企业用户:在客户服务和技术支持中使用,提高自动化水平和效率。","教育领域:作为教学工具,帮助学生更好地理解复杂的语言问题。","内容创作者:辅助生成创意写作内容,提高创作效率。"]

使用场景示例:

在客户服务中自动回答常见问题。

作为智能助手,帮助用户解决日常任务和查询。

在教育平台中辅助学生学言和理解复杂概念。

产品特色:

对话式问答(QA):能够理解和回答复杂的对话式问题。

检索增强型生成(RAG):结合检索到的信息生成更丰富、更准确的回答。

增强的表格和算术计算能力:特别优化了对表格数据和数学问题的理解和处理。

多语言支持:虽然主要是英文,但具备处理多语言的能力。

高效的文本生成:能够快速生成流畅且相关的文本。

上下文感知:能够利用给定的上下文信息提供更准确的回答。

自定义化能力:允许用户根据特定需求调整和优化模型。

使用教程:

步骤1:导入必要的库和模块,如 AutoTokenizer 和 AutoModelForCausalLM。

步骤2:使用模型的ID初始化 tokenizer 和 model。

步骤3:准备对话消息和上下文文档。

步骤4:将消息和文档格式化为模型所需的输入格式。

步骤5:使用模型生成回答,可以通过设置 max_new_tokens 参数来控制生成文本的长度。

步骤6:解码生成的文本,去除特殊标记,并获取最终的回答。

Llama3-ChatQA-1.5-70B官网入口网址

小编发现Llama3-ChatQA-1.5-70B网站非常受用户欢迎,请访问Llama3-ChatQA-1.5-70B网址入口试用。

数据统计

数据评估

本站Home提供的Llama3-ChatQA-1.5-70B都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2024年 7月 4日 下午9:31收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。