LLaVA++官网

LLaVA++是一个开源项目,旨在通过集成Phi-3和LLaMA-3模型来扩展LLaVA模型的视觉能力。该项目由Mohamed bin Zayed University of AI (MBZUAI)的研究人员开发,通过结合最新的大型语言模型,增强了模型在遵循指令和学术任务导向数据集上的表现。

LLaVA++是什么

LLaVA++是由MBZUAI的研究人员开发的开源项目,它通过整合Phi-3和LLaMA-3模型,显著增强了LLaVA视觉语言模型的能力。简单来说,它让LLaVA模型更好地理解图像和文本之间的关联,并能更准确地执行指令和完成各种任务。这个项目的目标是提升视觉与语言模型的交互能力,使其在学术研究和商业应用中都有更广泛的用途。

LLaVA++的主要功能

LLaVA++的主要功能在于提升LLaVA模型的视觉和语言理解能力。它通过集成Phi-3和LLaMA-3这两个强大的语言模型,实现了以下功能:更精准的指令遵循、更优异的学术任务表现、更强大的图像文本理解能力、提供预训练模型和LoRA权重微调模型,以适应不同的使用场景,并通过Google Colab提供交互式体验。

如何使用LLaVA++

使用LLaVA++相对简单,步骤如下:

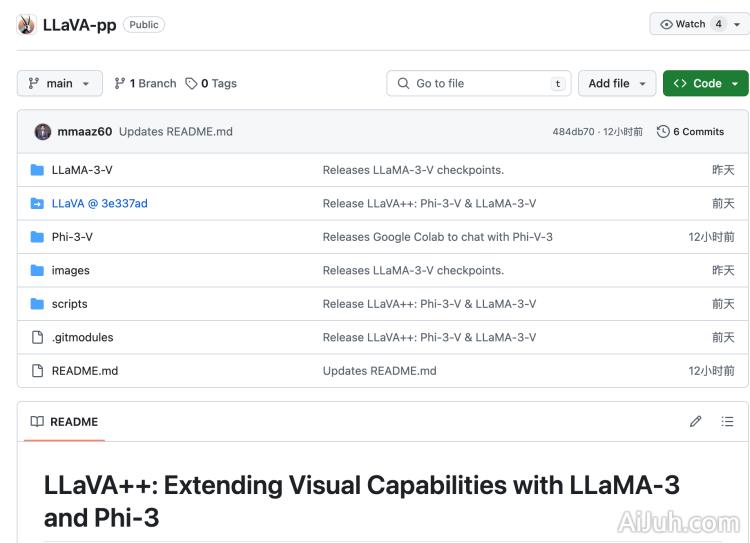

1. 访问GitHub项目页面(https://github.com/mbzuai-oryx/LLaVA-pp),下载代码库。

2. 按照安装指南安装必要的依赖包。

3. 选择预训练模型或进行模型微调,以适应你的应用场景。

4. 使用Google Colab体验交互式功能。

5. 根据文档进行模型训练和测试,评估模型性能。

6. 将训练好的模型集成到你的应用中。

LLaVA++的产品价格

LLaVA++是一个开源项目,完全免费使用。

LLaVA++常见问题

LLaVA++的系统要求是什么? LLaVA++的系统要求取决于你选择的模型和任务。建议参考GitHub上的详细说明,选择适合你硬件配置的模型。

如何对LLaVA++进行微调以适应我的特定任务? LLaVA++提供了LoRA权重微调,这允许你使用相对较少的计算资源来调整模型以适应你的特定数据集和任务。详细的微调指南可以在GitHub项目页面找到。

LLaVA++与其他视觉语言模型相比有哪些优势? LLaVA++通过整合Phi-3和LLaMA-3模型,在多个基准测试中展现了其在指令遵循和学术任务上的优越性能。具体优势可以在项目页面上的论文和报告中找到。

LLaVA++官网入口网址

https://github.com/mbzuai-oryx/LLaVA-pp

OpenI小编发现LLaVA++网站非常受用户欢迎,请访问LLaVA++网址入口试用。

数据统计

数据评估

本站Home提供的LLaVA++都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2025年 1月 10日 上午11:56收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。