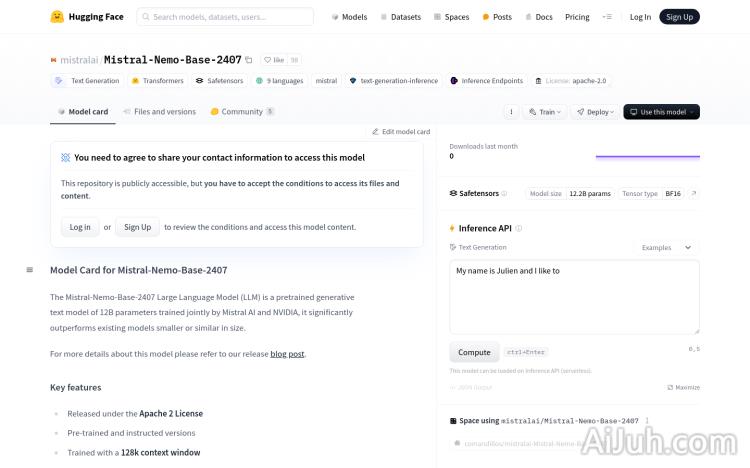

Mistral-Nemo-Base-2407官网

12B参数的大型语言模型

Mistral-Nemo-Base-2407简介

需求人群:

"Mistral-Nemo-Base-2407模型适合需要进行高质量文本生成的开发者和研究人员。其多语言和代码数据训练能力使其在多语言文本生成、代码生成等领域具有优势。同时,其预训练和指令版本的特性也使其在自然语言处理任务中具有广泛的应用前景。"

使用场景示例:

用于生成高质量的多语言文本,如新闻文章、博客文章等

在编程领域,辅助生成代码或文档

在教育领域,辅助学生理解和生成自然语言文本

产品特色:

支持多种语言和代码数据的文本生成

128k上下文窗口训练,提升文本理解和生成能力

预训练和指令版本,满足不同应用需求

Apache 2.0许可证发布,使用灵活

模型架构包括40层、5120维、128头维,优化模型性能

在多个基准测试中表现出色,如HellaSwag、Winogrande等

支持多种框架使用,如mistral_inference、transformers、NeMo

使用教程:

1. 安装mistral_inference:推荐使用mistralai/Mistral-Nemo-Base-2407与mistral-inference。

2. 下载模型:使用Hugging Face Hub的snapshot_download函数下载模型文件。

3. 安装transformers:如果需要使用Hugging Face transformers生成文本,需要从源代码安装transformers。

4. 使用模型:通过AutoModelForCausalLM和AutoTokenizer加载模型和分词器,输入文本并生成输出。

5. 调整参数:与之前的Mistral模型不同,Mistral Nemo需要较小的温度,推荐使用0.3。

6. 运行演示:安装mistral_inference后,环境中应可用mistral-demo CLI命令。

Mistral-Nemo-Base-2407官网入口网址

小编发现Mistral-Nemo-Base-2407网站非常受用户欢迎,请访问Mistral-Nemo-Base-2407网址入口试用。

数据统计

数据评估

本站Home提供的Mistral-Nemo-Base-2407都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2024年 7月 19日 下午12:06收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。