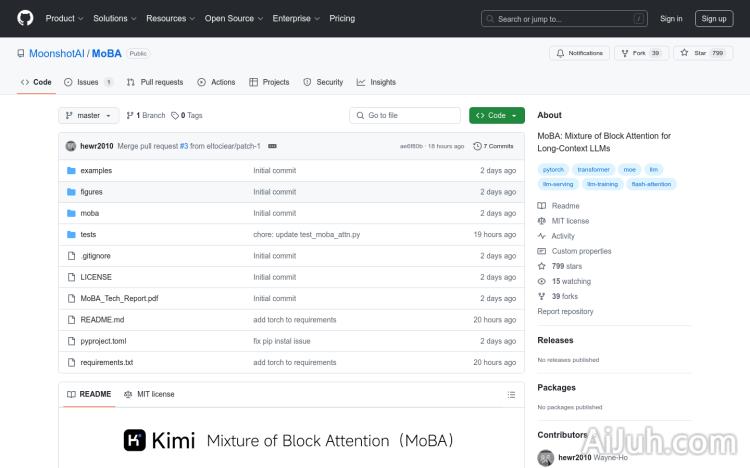

MoBA官网

MoBA(Mixture of Block Attention)是一种创新的注意力机制,专为长文本上下文的大语言模型设计。它通过将上下文划分为块,并让每个查询令牌学习关注最相关的块,从而实现高效的长序列处理。MoBA 的主要优点是能够在全注意力和稀疏注意力之间无缝切换,既保证了性能,又提高了计算效率。该技术适用于需要处理长文本的任务,如文档分析、代码生成等,能够显著降低计算成本,同时保持模型的高性能表现。MoBA 的开源实现为研究人员和开发者提供了强大的工具,推动了大语言模型在长文本处理领域的应用。

MoBA是什么

MoBA (Mixture of Block Attention) 是一种针对长文本上下文的大语言模型设计的创新注意力机制。它通过将上下文分割成块,并让每个查询令牌选择最相关的块进行处理,从而高效地处理长序列。MoBA 的优势在于能够在全注意力和稀疏注意力之间灵活切换,既保证了模型性能,又提升了计算效率。这使得它非常适合处理文档分析、代码生成等需要处理长文本的任务,显著降低计算成本的同时保持高性能表现。MoBA 提供了开源实现,方便研究人员和开发者使用。

MoBA的主要功能

MoBA 的核心功能是高效处理长文本上下文。它通过混合块注意力机制,选择性地关注最相关的文本块,从而避免了传统全注意力机制在长序列处理中的计算瓶颈。其主要功能包括:可训练的块稀疏注意力机制、无参数 Top-k 门控机制、全注意力和稀疏注意力模式无缝切换、与现有 Transformer 架构兼容、支持 1M 长上下文的高效计算以及支持 Flash Attention 进一步优化性能。

如何使用MoBA

MoBA 的使用相对简单,主要步骤如下:

- 创建 Python 虚拟环境并安装依赖:

conda create -n moba python=3.10,激活环境后运行pip install .。 - 使用 MoBA 替换传统注意力机制:在代码中指定

--attn moba参数。 - 运行示例代码:

python3 examples/llama.py --model meta-llama/Llama-3.1-8B --attn moba。 - 使用单元测试验证 MoBA 的正确性:运行

pytest tests/test_moba_attn.py。 - 根据需求调整 MoBA 参数,例如块大小和稀疏度,以优化性能。

MoBA的产品价格

MoBA 是一款开源项目,免费提供给所有用户使用。

MoBA的常见问题

MoBA 支持哪些类型的 Transformer 模型? MoBA 与大多数现有的 Transformer 架构兼容,可以轻松集成到各种模型中。

MoBA 如何处理不同长度的文本? MoBA 会根据文本长度自动调整块大小和稀疏度,以确保高效的计算。

MoBA 的性能与其他注意力机制相比如何? MoBA 在处理长文本时,在性能和效率方面都优于传统的全注意力机制,同时保持了与稀疏注意力机制相当的性能。

MoBA官网入口网址

https://github.com/MoonshotAI/MoBA

OpenI小编发现MoBA网站非常受用户欢迎,请访问MoBA网址入口试用。

数据统计

数据评估

本站Home提供的MoBA都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2025年 2月 24日 下午3:57收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。