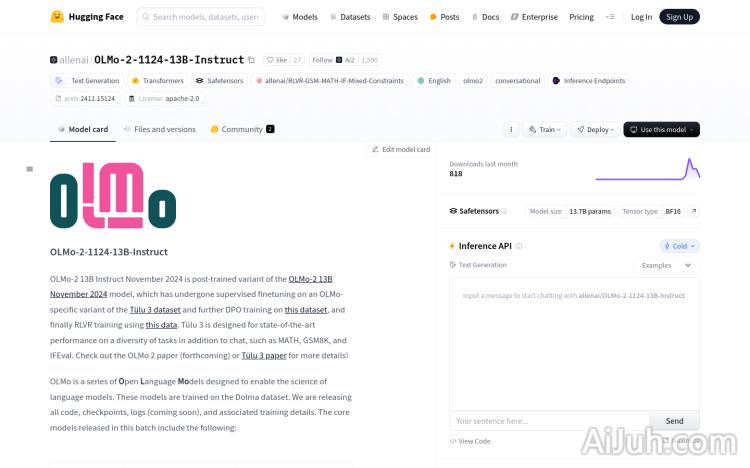

OLMo-2-1124-13B-Instruct官网

一款经过优化的大型语言模型,擅长文本生成和对话。

OLMo-2-1124-13B-Instruct简介

需求人群:

"目标受众为研究人员、开发者和企业用户,他们需要一个强大的、可定制的自然语言处理工具来构建或增强他们的应用程序。由于其在多任务学习中的表现,它特别适合需要处理复杂语言任务的场景。"

使用场景示例:

案例一:研究人员使用OLMo-2-1124-13B-Instruct模型来生成科学论文的摘要。

案例二:开发者将模型集成到应用中,以提供更自然的对话体验。

案例三:企业使用该模型来自动化客户服务中的常见问题解答。

产品特色:

• 强大的文本生成能力:能够生成各种类型的文本内容。

• 对话管理:优化的对话模板,使得模型在对话场景中表现更自然。

• 多任务学习:在数学、科学等领域的问答任务上表现优异。

• 安全性训练:有限的安全训练,减少了生成不当内容的风险。

• 开源代码和数据:所有代码、检查点和日志均开源,便于社区贡献和改进。

• 灵活部署:支持在Hugging Face平台上直接加载和使用。

• 高性能:在多个基准测试中表现优异,如AlpacaEval、BBH等。

使用教程:

1. 安装Transformers库:在命令行中运行`pip install –upgrade git+https://github.com/huggingface/transformers.git`。

2. 加载模型:使用Python代码`from transformers import AutoModelForCausalLM; olmo_model = AutoModelForCausalLM.from_pretrained("allenai/OLMo-2-1124-13B-Instruct")`来加载模型。

3. 使用模型:根据需要,将文本输入到模型中,并获取生成的输出。

4. 微调模型:如果需要,可以在特定数据集上对模型进行微调,以适应特定的应用场景。

5. 部署模型:将训练好的模型部署到生产环境中,以提供服务。

6. 监控和评估:定期监控模型性能,并根据反馈进行调整和优化。

OLMo-2-1124-13B-Instruct官网入口网址

小编发现OLMo-2-1124-13B-Instruct网站非常受用户欢迎,请访问OLMo-2-1124-13B-Instruct网址入口试用。

数据统计

数据评估

本站Home提供的OLMo-2-1124-13B-Instruct都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2024年 12月 25日 上午9:23收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。