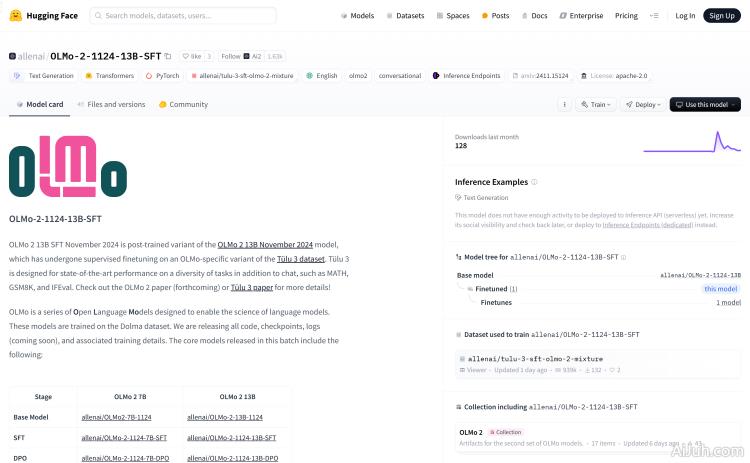

OLMo-2-1124-13B-SFT官网

OLMo-2-1124-13B-SFT是由Allen AI研究所开发的一个大型语言模型,经过在特定数据集上的监督微调,旨在提高在多种任务上的表现,包括、数学问题解答、文本生成等。该模型基于Transformers库和PyTorch框架,支持英文,拥有Apache 2.0的开源许可证,适用于研究和教育用途。

OLMo-2-1124-13B-SFT是什么

OLMo-2-1124-13B-SFT是由Allen AI研究所开发的一个大型语言模型。它经过监督微调,在多种任务上表现出色,包括、解答数学问题和文本生成等。该模型基于Transformers库和PyTorch框架,支持英文,并采用Apache 2.0开源许可证,主要面向研究和教育用途。

OLMo-2-1124-13B-SFT的主要功能

OLMo-2-1124-13B-SFT的主要功能包括:文本生成、、数学问题解答以及更广泛的自然语言处理任务。它能够生成高质量的文本,并胜任多种复杂语言理解和生成任务。

如何使用OLMo-2-1124-13B-SFT

使用OLMo-2-1124-13B-SFT非常便捷:首先,访问Hugging Face网站并搜索该模型。然后,使用提供的代码片段加载模型(from transformers import AutoModelForCausalLM; olmo_model = AutoModelForCausalLM.from_pretrained("allenai/OLMo-2-1124-13B-SFT"))。接下来,根据你的需求调整模型参数,进行微调或直接使用。最后,利用模型进行文本生成或其他NLP任务,并遵守Apache 2.0许可证。

OLMo-2-1124-13B-SFT的产品价格

OLMo-2-1124-13B-SFT是一个开源模型,因此免费使用,但用户需要自行承担计算资源成本。

OLMo-2-1124-13B-SFT的常见问题

该模型的运行需要哪些硬件资源? 这取决于你想要执行的任务的复杂性和规模。对于简单的任务,可能只需要一个具有强大GPU的个人电脑;而对于更复杂的任务,则可能需要云计算平台上的高性能GPU集群。

如何评估OLMo-2-1124-13B-SFT的性能? 可以使用标准的NLP评估指标,例如BLEU分数(用于机器翻译)、ROUGE分数(用于文本摘要)以及困惑度(用于语言建模),来评估模型在不同任务上的性能。还可以通过人工评估来判断生成文本的质量。

OLMo-2-1124-13B-SFT支持哪些语言? 目前主要支持英文,但未来可能会支持其他语言,具体取决于模型的进一步开发和训练。

OLMo-2-1124-13B-SFT官网入口网址

https://huggingface.co/allenai/OLMo-2-1124-13B-SFT

OpenI小编发现OLMo-2-1124-13B-SFT网站非常受用户欢迎,请访问OLMo-2-1124-13B-SFT网址入口试用。

数据统计

数据评估

本站Home提供的OLMo-2-1124-13B-SFT都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2025年 1月 9日 下午9:24收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。