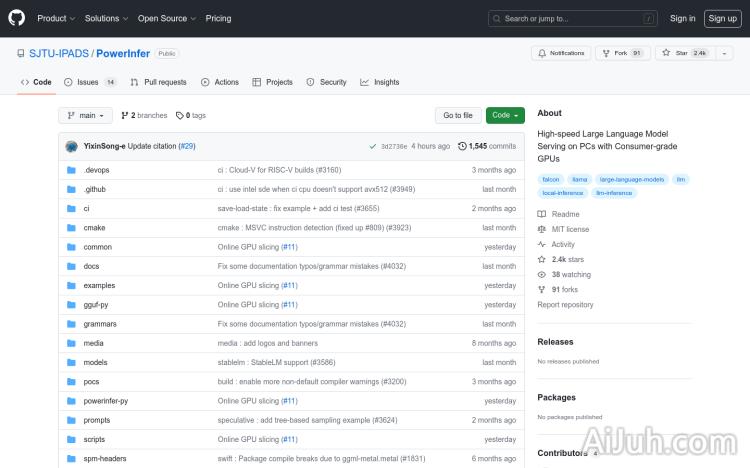

PowerInfer官网

高速大型语言模型本地部署推理引擎

PowerInfer简介

需求人群:

"PowerInfer 适用于在本地部署大型语言模型的高速推理。"

产品特色:

利用稀疏激活和 “热”/“冷” 神经元概念进行高效的 LLM 推理

无缝集成 CPU 和 GPU 的内存 / 计算能力,实现负载均衡和更快的处理速度

与常见的 ReLU 稀疏模型兼容

设计和深度优化用于本地部署在消费级硬件上,实现低延迟的 LLM 推理和服务

向后兼容性,支持与 llama.cpp 相同的模型权重进行推理,但不会有性能提升

PowerInfer官网入口网址

https://github.com/SJTU-IPADS/PowerInfer

小编发现PowerInfer网站非常受用户欢迎,请访问PowerInfer网址入口试用。

数据统计

数据评估

关于PowerInfer特别声明

本站Home提供的PowerInfer都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2024年 1月 10日 下午7:45收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。

相关导航

暂无评论...