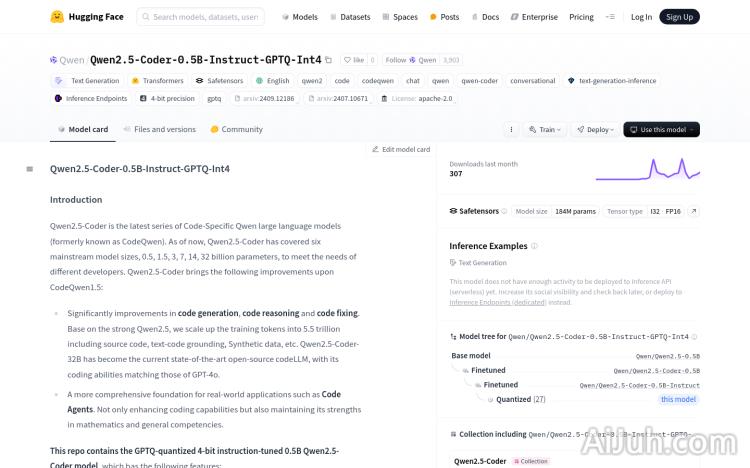

Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4官网

Qwen2.5-Coder是Qwen大型语言模型的最新系列,专注于代码生成、代码推理和代码修复。基于强大的Qwen2.5,该模型在训练中涵盖了5.5万亿的源代码、文本代码基础、合成数据等,成为当前开源代码语言模型的最新技术。该模型不仅在编程能力上与GPT-4o相匹配,还在数学和一般能力上保持了优势。Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4模型是经过GPTQ量化的4位指令调整模型,具有因果语言模型、预训练和后训练、transformers架构等特点。

Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4是什么

Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4是一个开源的代码生成、推理和修复模型。它是基于Qwen2.5大型语言模型构建的,经过GPTQ量化处理,参数量为0.5B,使用4位整数精度(Int4)进行运算,从而在保持性能的同时降低了计算和存储资源的需求。该模型在海量代码数据上进行训练,能够理解和生成多种编程语言的代码,并具备代码推理和修复能力,其性能与GPT-4o相当,甚至在某些数学和通用任务上表现更优。

Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4主要功能

Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4 的主要功能包括:代码生成、代码推理和代码修复。它支持多种编程语言,可以根据用户的需求生成各种类型的代码,帮助开发者快速完成编码任务。同时,它还能分析代码逻辑,找出代码中的错误并进行修复,提高代码质量和开发效率。此外,该模型还具有因果语言模型特性,并采用Transformer架构。

如何使用Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4

使用该模型需要安装transformers和torch库。然后,从Hugging Face加载模型和分词器。准备输入提示(例如,编写算法的需求),使用分词器处理输入,并将其传递给模型进行代码生成。最后,将生成的代码ID转换为文本形式即可。具体步骤如下:

- 安装必要的库:

pip install transformers torch - 加载模型和分词器:

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4")和tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4") - 准备输入提示

- 处理输入:

inputs = tokenizer.apply_chat_template(messages=your_input) - 生成代码:

outputs = model.generate(**inputs,max_new_tokens=512) - 解码输出:

generated_code = tokenizer.batch_decode(outputs,skip_special_tokens=True)

Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4产品价格

该模型是开源的,因此免费使用。

Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4常见问题

该模型支持哪些编程语言? 该模型支持多种编程语言,具体支持的语言范围需要参考官方文档。

该模型的性能如何? 该模型的性能与GPT-4o相当,甚至在某些数学和通用任务上表现更优,但实际性能会因任务和输入而异。

如何处理模型输出的错误? 模型输出可能包含错误,需要开发者进行检查和调试。建议结合人工经验和其它工具进行代码审核。

Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4官网入口网址

https://huggingface.co/Qwen/Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4

OpenI小编发现Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4网站非常受用户欢迎,请访问Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4网址入口试用。

数据统计

数据评估

本站Home提供的Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2025年 1月 10日 上午4:36收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。