s1-32B官网

s1是一个推理模型,专注于通过少量样本实现高效的文本生成能力。它通过预算技术在测试时进行扩展,能够匹配o1-preview的性能。该模型由Niklas Muennighoff等人开发,相关研究发表在arXiv上。模型使用Safetensors技术,具有328亿参数,支持文本生成任务。其主要优点是能够通过少量样本实现高质量的推理,适合需要高效文本生成的场景。

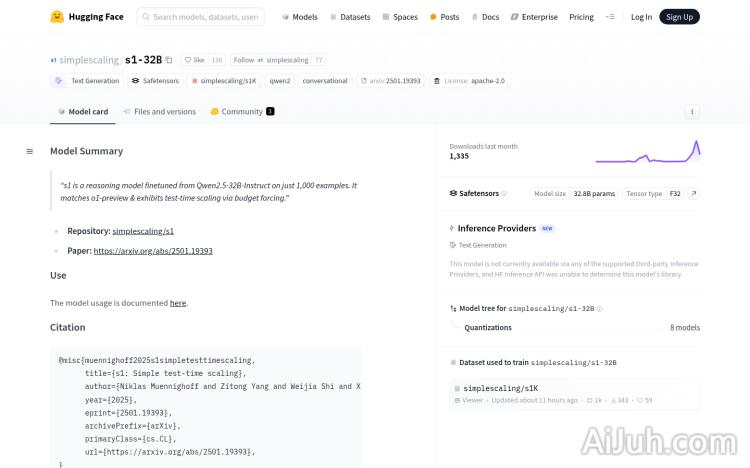

s1-32B是什么?

s1-32B是一个高效的文本生成推理模型,由Niklas Muennighoff等人开发,基于Qwen2.5-32B-Instruct微调而成。它拥有328亿个参数,但仅使用了1000个样本进行训练,就能达到令人印象深刻的性能,这得益于其采用的预算技术。该模型开源,并支持Safetensors技术,确保模型的安全性和稳定性。它在少量样本学习方面表现出色,非常适合需要高效文本生成的应用场景。

s1-32B的主要功能

s1-32B的主要功能是文本生成。它可以用于各种自然语言处理任务,例如:智能客服系统中的自动回复生成、自动写作工具中的文章和故事创作、对话机器人中的自然语言理解和生成等。其高效的学习能力和推理能力使其成为这些应用场景的理想选择。

如何使用s1-32B

使用s1-32B相对简单:首先,访问Hugging Face模型页面下载模型文件;然后,安装必要的依赖库,如Safetensors和transformers;接下来,加载模型并进行推理,可以根据需求使用少量样本进行微调;最后,调用模型生成文本,并利用预算技术优化输出,将其集成到你的应用程序中。

s1-32B的产品价格

s1-32B是一个开源模型,这意味着它是免费使用的。你不需要支付任何费用来下载、使用或分发该模型。

s1-32B的常见问题

s1-32B的性能与其他大型语言模型相比如何? s1-32B虽然只使用了1000个样本进行训练,但在特定任务上的表现可以与一些参数量更大的模型相媲美,尤其是在推理效率方面具有显著优势。

s1-32B的运行需要多少算力? 这取决于你的具体应用和硬件配置。对于简单的文本生成任务,相对较低的算力即可满足需求。对于更复杂的应用,则可能需要更强大的GPU。

s1-32B是否支持中文? 虽然官方文档未明确说明,但考虑到其基于Qwen2.5-Instruct微调,并且用于文本生成的特性,它应该支持中文,但实际效果可能需要测试验证。

s1-32B官网入口网址

https://huggingface.co/simplescaling/s1-32B

OpenI小编发现s1-32B网站非常受用户欢迎,请访问s1-32B网址入口试用。

数据统计

数据评估

本站Home提供的s1-32B都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2025年 2月 8日 下午8:59收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。