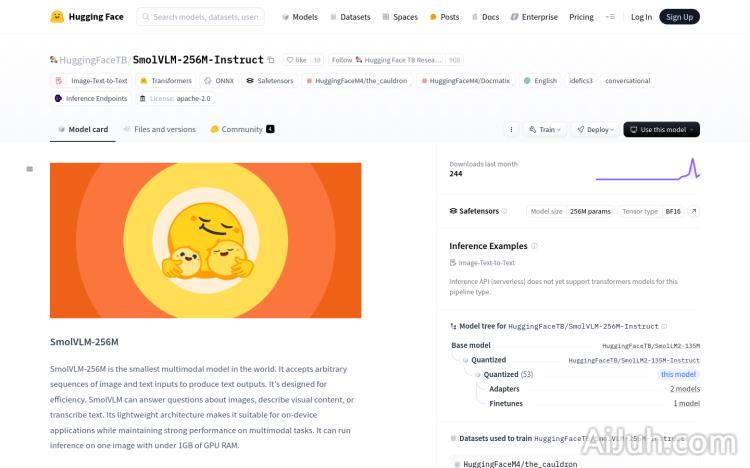

SmolVLM-256M-Instruct官网

SmolVLM-256M 是由 Hugging Face 开发的多模态模型,基于 Idefics3 架构,专为高效处理图像和文本输入而设计。它能够回答关于图像的问题、描述视觉内容或转录文本,且仅需不到 1GB 的 GPU 内存即可运行推理。该模型在多模态任务上表现出色,同时保持轻量化架构,适合在设备端应用。其训练数据来自 The Cauldron 和 Docmatix 数据集,涵盖文档理解、图像描述等多领域内容,使其具备广泛的应用潜力。目前该模型在 Hugging Face 平台上免费提供,旨在为开发者和研究人员提供强大的多模态处理能力。

SmolVLM-256M-Instruct是什么?

SmolVLM-256M-Instruct是由Hugging Face开发的一个轻量级多模态模型。它能够高效地处理图像和文本输入,并生成文本输出,例如回答关于图像的问题、生成图像描述或进行文本转录。它最大的特点在于其小巧的模型体积,只需不到1GB的GPU内存即可运行,非常适合在资源受限的设备上使用。该模型在多种多模态任务上表现出色,并且在Hugging Face平台上免费提供。

SmolVLM-256M-Instruct的主要功能

SmolVLM-256M-Instruct的主要功能包括:图像问答、图像字幕生成、基于图像内容的故事创作以及更通用的多模态文本生成。它可以根据输入的图像回答相关问题,为图像生成描述性字幕,甚至可以根据图像内容创作故事。 其高效的处理能力使其能够灵活地适应多种多模态任务。

如何使用SmolVLM-256M-Instruct

使用SmolVLM-256M-Instruct需要使用transformers库。具体步骤如下:首先,使用`AutoProcessor`和`AutoModelForVision2Seq`加载预训练模型和处理器;然后,准备输入数据,包括图像和相关的文本信息;接着,使用处理器将输入数据转换为模型可接受的格式;接下来,将处理后的数据传递给模型进行推理,生成文本输出;最后,使用处理器解码生成的文本ID,获得最终的文本结果。

SmolVLM-256M-Instruct的产品价格

SmolVLM-256M-Instruct目前在Hugging Face平台上免费提供。

SmolVLM-256M-Instruct的常见问题

SmolVLM-256M-Instruct的处理速度如何? 由于其轻量化架构,SmolVLM-256M-Instruct的处理速度非常快,能够快速生成结果,尤其在资源受限的设备上表现突出。

SmolVLM-256M-Instruct支持哪些类型的图像? SmolVLM-256M-Instruct支持多种常见的图像格式,具体支持的格式请参考Hugging Face平台上的官方文档。

SmolVLM-256M-Instruct的输出质量如何? SmolVLM-256M-Instruct的输出质量与训练数据和模型架构有关,总体来说,它能够生成比较准确和流畅的文本输出,但在某些复杂场景下可能存在一定的局限性。 建议在使用前仔细阅读相关的文档和示例。

SmolVLM-256M-Instruct官网入口网址

https://huggingface.co/HuggingFaceTB/SmolVLM-256M-Instruct

OpenI小编发现SmolVLM-256M-Instruct网站非常受用户欢迎,请访问SmolVLM-256M-Instruct网址入口试用。

数据统计

数据评估

本站Home提供的SmolVLM-256M-Instruct都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2025年 2月 7日 上午10:51收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。