Wan2.1-T2V-14B官网

Wan2.1-T2V-14B 是一款先进的文本到视频生成模型,基于扩散变换器架构,结合了创新的时空变分自编码器(VAE)和大规模数据训练。它能够在多种分辨率下生成高质量的视频内容,支持中文和英文文本输入,并在性能和效率上超越现有的开源和商业模型。该模型适用于需要高效视频生成的场景,如内容创作、广告制作和视频编辑等。目前该模型在 Hugging Face 平台上免费提供,旨在推动视频生成技术的发展和应用。

Wan2.1-T2V-14B是什么

Wan2.1-T2V-14B是一款强大的开源文本到视频生成模型,它能够根据文本描述或图像生成高质量的视频。该模型基于扩散变换器架构和时空变分自编码器(VAE),并经过大规模数据训练,在性能和效率上都领先于许多现有模型。它支持中文和英文输入,能够在多种分辨率下生成视频,应用范围广泛,包括内容创作、广告制作和视频编辑等。

Wan2.1-T2V-14B主要功能

Wan2.1-T2V-14B的主要功能包括文本到视频生成、图像到视频生成,支持多种语言(中文和英文)输入,并能生成不同分辨率(480P和720P)的视频。此外,它还具有高效的时空压缩能力,能够处理1080P视频,并提供单GPU和多GPU推理代码,以适应不同的硬件需求。

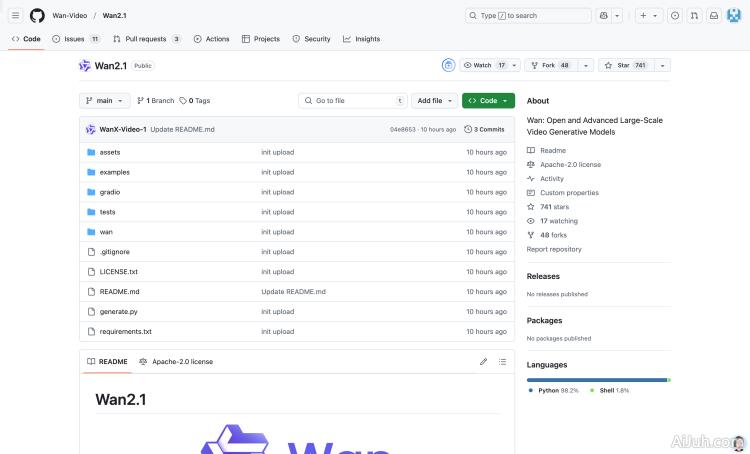

Wan2.1-T2V-14B使用方法

使用Wan2.1-T2V-14B生成视频非常简单,只需要按照以下步骤操作:

- 克隆项目仓库:

git clone https://github.com/Wan-Video/Wan2.1.git - 安装依赖:

pip install -r requirements.txt - 下载模型权重:

huggingface-cli download Wan-AI/Wan2.1-T2V-14B --local-dir ./Wan2.1-T2V-14B - 运行文本到视频生成:

python generate.py --task t2v-14B --size 1280*720 --ckpt_dir ./Wan2.1-T2V-14B --prompt '描述文本'(将’描述文本’替换成你的文本描述) - 根据需要调整参数,例如分辨率、提示文本等。

Wan2.1-T2V-14B产品价格

Wan2.1-T2V-14B是一个开源模型,这意味着它是免费使用的。你只需要支付运行模型所需的计算资源费用(例如云服务器费用)。

Wan2.1-T2V-14B常见问题

生成的视频质量如何? 生成的视频质量取决于输入提示的清晰度和模型的训练数据。高质量的提示通常会产生更好的结果。模型目前支持480P和720P分辨率,更高分辨率的视频生成还在开发中。

需要什么样的硬件才能运行该模型? 运行Wan2.1-T2V-14B需要一定的计算资源。最低配置要求取决于你想要生成视频的分辨率和长度,但至少需要一块性能较好的GPU。官方提供单GPU和多GPU推理代码,以适应不同硬件需求。

如何改进生成的视频效果? 你可以尝试更详细、更具体的文本提示,或者尝试不同的提示词来微调生成结果。此外,还可以尝试使用图像作为输入,以获得更精准的视频效果。

Wan2.1-T2V-14B官网入口网址

https://huggingface.co/Wan-AI/Wan2.1-T2V-14B

OpenI小编发现Wan2.1-T2V-14B网站非常受用户欢迎,请访问Wan2.1-T2V-14B网址入口试用。

数据统计

数据评估

本站Home提供的Wan2.1-T2V-14B都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2025年 2月 28日 上午12:17收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。