InternVL2-8B-MPO官网

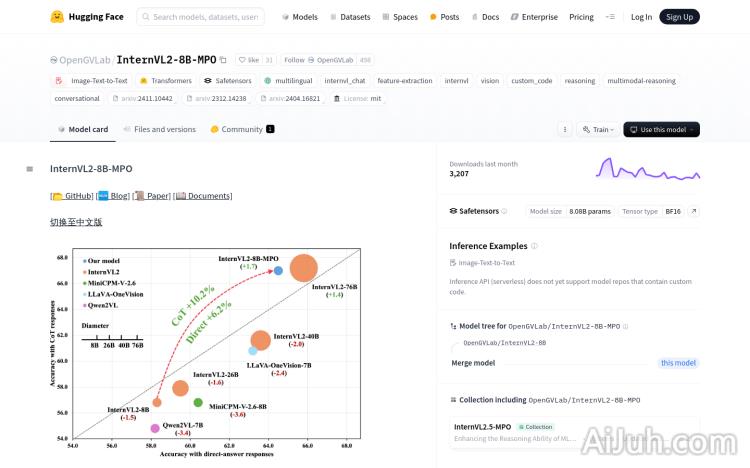

InternVL2-8B-MPO是一个多模态大语言模型(MLLM),通过引入混合偏好优化(MPO)过程,增强了模型的多模态推理能力。该模型在数据方面设计了自动化的偏好数据构建管线,并构建了MMPR这一大规模多模态推理偏好数据集。在模型方面,InternVL2-8B-MPO基于InternVL2-8B初始化,并使用MMPR数据集进行微调,展现出更强的多模态推理能力,且幻觉现象更少。该模型在MathVista上取得了67.0%的准确率,超越InternVL2-8B 8.7个点,且表现接近于大10倍的InternVL2-76B。

InternVL2-8B-MPO是什么

InternVL2-8B-MPO是一个强大的多模态大语言模型,它能够理解和处理图像和文本信息。通过混合偏好优化(MPO)技术,该模型在多模态推理能力方面有了显著提升,能够更准确地理解图像和文本之间的关联,并生成更可靠的结果。它基于InternVL2-8B模型进行改进,并在大型多模态推理偏好数据集MMPR上进行了微调,有效减少了模型的“幻觉”现象。

InternVL2-8B-MPO主要功能

InternVL2-8B-MPO的主要功能包括:图像描述生成、多图像推理(比较图像相似性和差异性)、以及在各种多模态任务中进行准确的推理。它在MathVista数据集上取得了67.0%的准确率,表现优异。该模型还支持多种语言,并能够在多个平台上进行微调,以适应不同的应用场景。

如何使用InternVL2-8B-MPO

使用InternVL2-8B-MPO相对简单,步骤如下:首先,安装必要的库,如transformers和torch;然后,使用AutoModel.from_pretrained加载模型;接着,准备包含文本和图像的输入数据;之后,使用模型进行推理并生成输出;最后,根据需要对输出进行后处理,例如文本格式化或图像显示。如果需要,还可以使用LMDeploy进行模型部署,以及根据具体需求对模型进行微调。

InternVL2-8B-MPO产品价格

本文未提供InternVL2-8B-MPO的价格信息。建议访问其官网或联系相关技术支持获取价格详情。

InternVL2-8B-MPO常见问题

InternVL2-8B-MPO的运行环境要求是什么? 需要安装PyTorch和Transformers等库,并具备足够的GPU资源才能有效运行。

如何评估InternVL2-8B-MPO的模型性能? 可以使用公开的多模态数据集,例如MathVista,来评估模型在不同任务上的准确率和效率。

InternVL2-8B-MPO支持哪些类型的图像和文本输入? 支持多种图像格式和多种语言的文本输入,具体支持的格式和语言类型请参考官方文档。

InternVL2-8B-MPO官网入口网址

https://huggingface.co/OpenGVLab/InternVL2-8B-MPO

OpenI小编发现InternVL2-8B-MPO网站非常受用户欢迎,请访问InternVL2-8B-MPO网址入口试用。

数据统计

数据评估

本站Home提供的InternVL2-8B-MPO都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2025年 1月 9日 下午8:51收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。