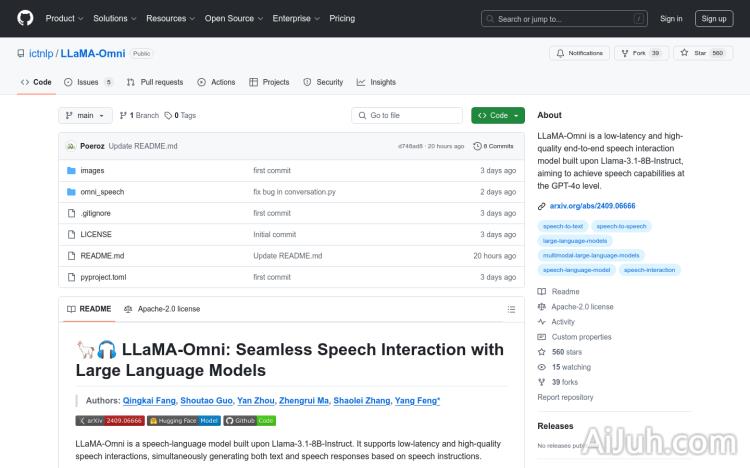

LLaMA-Omni官网

LLaMA-Omni是一个基于Llama-3.1-8B-Instruct构建的低延迟、高质量的端到端语音交互模型,旨在实现GPT-4o级别的语音能力。该模型支持低延迟的语音交互,能够同时生成文本和语音响应。它在不到3天的时间内使用仅4个GPU完成训练,展示了其高效的训练能力。

LLaMA-Omni是什么

LLaMA-Omni是一款基于Llama-3.1-8B-Instruct构建的端到端语音交互模型。它旨在提供低延迟、高质量的语音交互体验,目标是达到GPT-4o级别的语音能力。这意味着它能够快速、准确地理解你的语音指令,并以文本或语音形式给出回应。令人印象深刻的是,它仅用4个GPU在不到3天的时间内就完成了训练,展现了其高效的训练能力。

LLaMA-Omni的主要功能

LLaMA-Omni的核心功能是实现低延迟、高质量的语音交互。它支持同时生成文本和语音响应,这意味着你可以用语音提问,然后得到语音或文字的答案。其应用场景广泛,可以用于开发各种语音交互系统,例如智能语音助手、智能家居控制系统和客服机器人等。

如何使用LLaMA-Omni

LLaMA-Omni的使用相对来说比较技术性,需要一定的编程基础。首先你需要克隆LLaMA-Omni的GitHub仓库到本地,安装必要的依赖包,包括fairseq和flash-attention。然后,你需要下载Llama-3.1-8B-Omni模型、Whisper-large-v3模型和基于单元的HiFi-GAN声码器。安装完成后,你可以启动Gradio演示进行交互式体验,或者使用提供的本地推理脚本进行本地测试。 对于本地推理,你需要按照指定格式准备语音指令文件。

LLaMA-Omni产品价格

LLaMA-Omni是一个开源项目,因此它是免费使用的。你只需要支付运行模型所需的计算资源成本。

LLaMA-Omni常见问题

LLaMA-Omni的硬件要求是什么?

LLaMA-Omni的运行需要一定的计算资源。虽然训练只需要4个GPU,但本地推理的资源需求会根据模型大小和语音长度而有所不同。建议使用具有较强计算能力的设备。

LLaMA-Omni支持哪些语言?

LLaMA-Omni的语言支持能力取决于训练数据。目前官方文档并未明确说明支持的语言范围,需要进一步查阅相关资料或进行测试。

如果遇到错误或问题,在哪里可以寻求帮助?

你可以访问LLaMA-Omni的GitHub仓库,查看文档、提交问题或参与社区讨论。 开发者社区通常能够提供有效的帮助和支持。

LLaMA-Omni官网入口网址

https://github.com/ictnlp/LLaMA-Omni

OpenI小编发现LLaMA-Omni网站非常受用户欢迎,请访问LLaMA-Omni网址入口试用。

数据统计

数据评估

本站Home提供的LLaMA-Omni都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2025年 1月 10日 上午7:41收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。