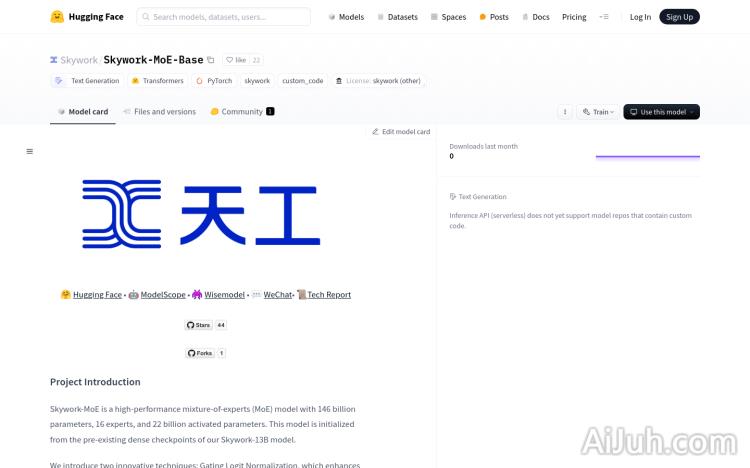

Skywork-MoE-Base官网

1460亿参数的高性能混合专家模型

Skywork-MoE-Base简介

需求人群:

"Skywork-MoE-Base模型适用于需要处理大规模语言模型推理的开发者和研究人员。其高性能和创新技术使其成为进行复杂文本生成和分析任务的理想选择。"

使用场景示例:

用于生成关于中国各省份省会的详细描述

进行多轮对话生成,如连续提问各省省会

快速部署用于研究和开发新的语言模型应用

产品特色:

具有1460亿参数的大规模混合专家模型

16个专家和220亿激活参数

引入门控逻辑归一化和自适应辅助损失系数两种创新技术

在多个基准测试中表现优越

支持Hugging Face模型推理

提供基于vLLM的快速部署方法

支持本地环境和Docker部署

使用教程:

步骤1: 安装必要的依赖项

步骤2: 克隆Skywork提供的vllm代码库

步骤3: 编译并安装vllm

步骤4: 根据需要选择本地环境或Docker部署

步骤5: 设置模型路径和工作目录

步骤6: 使用vllm运行Skywork MoE模型进行文本生成

Skywork-MoE-Base官网入口网址

小编发现Skywork-MoE-Base网站非常受用户欢迎,请访问Skywork-MoE-Base网址入口试用。

数据统计

数据评估

关于Skywork-MoE-Base特别声明

本站Home提供的Skywork-MoE-Base都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2024年 7月 4日 下午9:26收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。

相关导航

暂无评论...