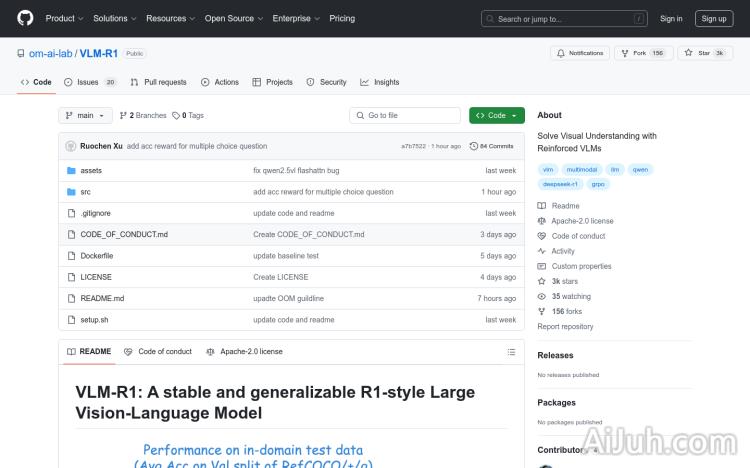

VLM-R1官网

VLM-R1 是一种基于强化学习的视觉语言模型,专注于视觉理解任务,如指代表达理解(Referring Expression Comprehension, REC)。该模型通过结合 R1(Reinforcement Learning)和 SFT(Supervised Fine-Tuning)方法,展示了在领域内和领域外数据上的出色性能。VLM-R1 的主要优点包括其稳定性和泛化能力,使其能够在多种视觉语言任务中表现出色。该模型基于 Qwen2.5-VL 构建,利用了先进的深度学习技术,如闪存注意力机制(Flash Attention 2),以提高计算效率。VLM-R1 旨在为视觉语言任务提供一种高效且可靠的解决方案,适用于需要精确视觉理解的应用场景。

VLM-R1是什么

VLM-R1是一款基于强化学习的视觉语言模型,专为提升视觉理解能力而设计,例如指代表达理解(REC)任务。它结合了强化学习(R1)和监督微调(SFT)方法,在领域内和领域外数据上都展现出优异的性能和泛化能力。VLM-R1基于Qwen2.5-VL构建,并利用了Flash Attention 2等先进技术来提高计算效率,为需要精确视觉理解的应用提供高效可靠的解决方案。简单来说,它是一个更擅长理解图像和文本之间关系的AI模型。

VLM-R1主要功能

VLM-R1的主要功能在于理解图像和文本的关联,尤其擅长指代表达理解。这意味着它能够根据对图像的自然语言描述,准确识别并定位图像中的目标对象。此外,它还支持多种数据格式,并提供GRPO(Guided Reinforcement Policy Optimization)训练方法,以提升模型的泛化能力,使其能够更好地处理各种不同的视觉语言任务。

如何使用VLM-R1

使用VLM-R1需要一定的技术基础。首先,需要克隆GitHub仓库并安装依赖项:`git clone https://github.com/om-ai-lab/VLM-R1.git`,然后运行`bash setup.sh`。接下来,准备数据集(例如COCO图像和指代表达理解标注文件),配置数据路径和模型参数(编辑`rec.yaml`文件),并使用GRPO方法训练模型(`bash src/open-r1-multimodal/run_grpo_rec.sh`)。最后,运行`python test_rec_r1.py`评估模型性能。

VLM-R1产品价格

目前关于VLM-R1的价格信息并未公开,建议访问其GitHub仓库或联系开发者获取相关信息。

VLM-R1常见问题

VLM-R1的训练需要多长时间? 这取决于数据集的大小和硬件配置。训练时间可能从数小时到数天不等。

VLM-R1支持哪些类型的图像? VLM-R1可以处理各种类型的图像,但其性能可能会因图像质量和内容而异。建议使用清晰、高质量的图像以获得最佳结果。

如何自定义VLM-R1以适应我的特定任务? VLM-R1提供详细的训练和评估脚本,方便用户自定义数据加载和处理流程,并调整模型参数以适应特定需求。 文档中提供了详细的指导。

VLM-R1官网入口网址

https://github.com/om-ai-lab/VLM-R1

OpenI小编发现VLM-R1网站非常受用户欢迎,请访问VLM-R1网址入口试用。

数据统计

数据评估

本站Home提供的VLM-R1都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由Home实际控制,在2025年 2月 24日 下午4:01收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,Home不承担任何责任。